SEO Prédictif et GEO : Anticiper la Recherche à l'Ère Agentique

Sommaire Exécutif

Ce rapport de recherche exhaustif a pour vocation d'analyser la mutation tectonique que traverse l'industrie du Search Engine Optimization (SEO) à l'approche de 2026. L'avènement des modèles de langage massifs (LLM), l'intégration de l'intelligence artificielle générative dans les pages de résultats de recherche (SERP) via la Search Generative Experience (SGE) de Google, et l'émergence des agents autonomes reconfigurent radicalement l'économie de l'attention numérique.

Nous passons d'un web d'indexation, où l'objectif était de classer des documents, à un web de synthèse et d'action, où l'objectif est de fournir une réponse directe ou d'exécuter une tâche complexe. Ce document explore en profondeur les mécanismes du SEO Prédictif, les impératifs du Generative Engine Optimization (GEO), et fournit une feuille de route opérationnelle pour les marques et les éditeurs. L'analyse s'appuie sur des données techniques, des méthodologies de data science, et des études de cas spécifiques au marché, y compris le contexte français.

1. La Grande Mutation : Du Moteur de Recherche au Moteur de Réponse (2025-2026)

1.1 L'Effondrement du Modèle des "Dix Liens Bleus"

L'histoire du référencement naturel a longtemps été dominée par une métaphore bibliothécaire : le moteur de recherche comme un immense catalogueur de fiches. L'utilisateur formulait une requête, et le moteur lui présentait une liste de ressources potentielles. Ce paradigme, stable pendant deux décennies, s'est effrité avec l'arrivée des "Featured Snippets" et s'effondre définitivement en 2026 sous le poids de l'IA générative.

L'année 2026 marque la généralisation de ce que l'on nomme le "Moteur de Réponse". Google, sous la pression de concurrents natifs de l'IA comme Perplexity ou SearchGPT, a transformé son interface. La SGE (Search Generative Experience), désormais rebaptisée "AI Overviews", ne se contente plus d'indexer l'information ; elle la digère, la comprend sémantiquement, et la reformule pour offrir une réponse synthétique immédiate.

Cette transition n'est pas cosmétique ; elle modifie la nature même du trafic web. Les analystes prévoient une augmentation massive des recherches "zéro-clic", où l'utilisateur satisfait son besoin d'information sans jamais quitter la page de résultats. Certaines études estiment que jusqu'à 60 % des requêtes, notamment informationnelles, ne généreront plus de clic sortant vers un site web traditionnel. Pour les éditeurs de sites, cela représente une perte potentielle de volume de trafic brut considérable, obligeant à repenser les indicateurs de performance (KPIs) : la visibilité et l'influence remplacent le clic comme mesure première du succès en haut de l'entonnoir.

1.2 L'Ère de l'Internet Agentique et Autonome

Au-delà de la simple synthèse d'information, 2026 inaugure l'ère des agents autonomes ("Agentic AI"). Si les assistants de 2024 (comme Siri ou les premières versions de Gemini) pouvaient répondre à des questions simples, les systèmes de 2026 sont conçus pour l'action. Google pivote stratégiquement vers des agents capables de planifier, d'exécuter et de surveiller des tâches multi-étapes complexes sans intervention humaine continue.

L'implication pour le SEO est profonde : nous entrons dans l'ère de l'"Agentic SEO". Il ne s'agit plus seulement d'optimiser le contenu pour qu'il soit lu par un humain, mais pour qu'il soit utilisé par un agent logiciel. Prenons l'exemple d'un utilisateur demandant : "Organise mon voyage d'affaires à Lyon incluant un hôtel proche de la gare Part-Dieu avec salle de réunion et réserve un restaurant végétarien pour le soir." L'agent IA de 2026 ne va pas lister des liens. Il va :

- Interroger les disponibilités en temps réel via des API ou en naviguant sur les sites.

- Comparer les options selon des critères qualitatifs (avis, photos).

- Exécuter les transactions de réservation.

Pour une marque, être invisible aux yeux de cet agent signifie être exclu de l'économie transactionnelle automatisée. Le SEO devient une question d'interopérabilité technique et de clarté sémantique pour ces nouveaux "consommateurs machines".

1.3 La Nouvelle Hiérarchie : AEO, GEO et Search Everywhere

L'acronyme SEO ne suffit plus à capturer la complexité de l'écosystème de 2026. Nous assistons à la fragmentation de la recherche et à l'émergence de nouvelles disciplines :

- AEO (Answer Engine Optimization) : Cette discipline vise spécifiquement les moteurs de réponse et les assistants vocaux. L'objectif est de devenir la "réponse unique" citée oralement ou affichée en haut de l'écran. Elle exige une concision extrême, une structure de contenu en pyramide inversée (la réponse d'abord, les détails ensuite), et une autorité factuelle indiscutable.

- GEO (Generative Engine Optimization) : Plus large que l'AEO, le GEO vise à influencer les grands modèles de langage (LLM) dans leur phase d'entraînement ou de récupération (RAG - Retrieval Augmented Generation). L'enjeu est de maximiser la probabilité statistique que votre marque soit mentionnée, recommandée ou citée dans une réponse générée complexe. Cela passe par la gestion de l'entité de marque dans le Knowledge Graph et la multiplication des co-occurrences sémantiques positives.

- Search Everywhere Optimization : La recherche ne se limite plus à Google. Les utilisateurs, en particulier les jeunes générations, utilisent TikTok, Instagram, YouTube, Pinterest ou Reddit comme moteurs de recherche primaires. En 2026, une stratégie de visibilité doit être omnicanale. Si votre marque n'est pas présente là où l'audience cherche, elle n'existe pas, même si elle est première sur Google.

| Dimension | SEO Traditionnel (Web) | GEO / AEO (IA & Agents) |

|---|---|---|

| Cible | Algorithme de tri (Ranking) | Modèle de Langage (Synthèse) |

| Format | Liste de liens (SERP) | Réponse en langage naturel / Action |

| Objectif | Clic vers le site web | Citation / Exécution de tâche |

| Contenu | Mots-clés, Longueur, Backlinks | Faits, Entités, Gain d'Information |

| Succès | Position 1, Trafic Organique | Share of Voice, Sentiment, Conversion |

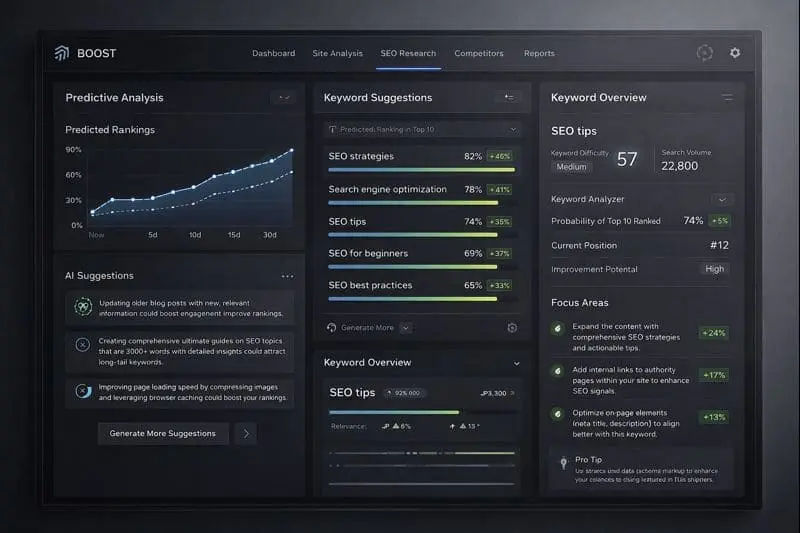

2. Le SEO Prédictif : La Science de la Donnée au Service de l'Anticipation

2.1 Définition et Rupture avec le SEO Réactif

Le SEO traditionnel a toujours été fondamentalement réactif : on analyse les volumes de recherche passés (via Google Keyword Planner) pour créer du contenu aujourd'hui. En 2026, cette approche est obsolète. Attendre que le volume de recherche apparaisse dans les outils tiers signifie arriver trop tard, alors que la concurrence est déjà installée. Le SEO prédictif renverse cette logique en utilisant la data science et l'apprentissage automatique (Machine Learning) pour anticiper la demande avant qu'elle ne se matérialise.

Le SEO prédictif ne consiste pas à deviner, mais à modéliser des probabilités. Il s'agit d'identifier les signaux faibles, les tendances saisonnières récurrentes et les corrélations externes pour projeter les besoins futurs des utilisateurs. Cela permet aux éditeurs de publier le contenu avant la courbe d'adoption, garantissant une indexation et une autorité établies au moment précis où la demande explose.

2.2 Méthodologies et Algorithmes de Prévision

La mise en œuvre du SEO prédictif repose sur des compétences techniques avancées, notamment l'utilisation du langage Python et de bibliothèques de traitement de données. Les experts SEO de 2026 sont hybrides, mi-marketeurs, mi-data scientists.

2.2.1 Analyse des Séries Temporelles (Time Series Analysis)

La base du SEO prédictif est l'analyse des séries temporelles. Des modèles comme ARIMA (AutoRegressive Integrated Moving Average) ou Prophet (développé par Meta) sont couramment utilisés pour décomposer l'historique de trafic ou de volume de recherche.

Ces modèles analysent trois composantes distinctes :

- La Tendance (Trend) : L'évolution de fond sur le long terme (ex: la croissance continue de l'intérêt pour l'IA).

- La Saisonnalité (Seasonality) : Les motifs répétitifs liés au calendrier (ex: pics pour "Black Friday" ou "Impôts").

- Les Résidus (Noise) : Les variations aléatoires non expliquées.

En isolant ces facteurs, un modèle Prophet peut prédire avec une précision remarquable le volume de recherche d'un mot-clé spécifique pour une semaine donnée dans six mois, permettant une planification éditoriale chirurgicale.

2.2.2 Modélisation de l'Intention et NLP

Au-delà du volume, le SEO prédictif s'intéresse à l'évolution de l'intention de recherche. Grâce au Traitement du Langage Naturel (NLP), on peut analyser comment le vocabulaire autour d'un sujet évolue. Une thématique commence souvent par des questions "Quoi" (Informationnel), glisse vers des comparaisons "Lequel" (Commercial), et finit par des requêtes "Prix/Achat" (Transactionnel). Les algorithmes de classification de texte (comme BERT ou ses successeurs) permettent de mapper le cycle de vie d'un sujet et de prédire le moment de bascule vers l'intention transactionnelle, optimisant ainsi le timing des offres commerciales.

2.3 Workflow Technique : Construire un Modèle Prédictif en Python

Pour les entreprises souhaitant internaliser cette compétence, voici le workflow standard utilisé par les équipes de data science SEO en 2026 :

- Collecte des Données (Data Ingestion) :

- Agrégation des données historiques de Google Search Console (GSC) via API.

- Importation des données de Google Trends (pytrends).

- Intégration de données exogènes (météo, indicateurs économiques, calendrier événements).

- Nettoyage des Données (Data Cleaning & Wrangling) :

- Utilisation de la bibliothèque Pandas pour structurer les données en DataFrames.

- Traitement des valeurs manquantes (imputation) et suppression des anomalies (outliers) dues à des bugs de tracking ou des événements exceptionnels non reproductibles.

- Ingénierie des Fonctionnalités (Feature Engineering) :

- Création de variables explicatives (ex: "jours avant Noël", "variation taux d'intérêt").

- Transformation des données textuelles en vecteurs numériques pour l'analyse NLP.

- Entraînement et Validation du Modèle :

- Sélection de l'algorithme (ex: XGBoost pour la classification, Prophet pour la série temporelle).

- Division du jeu de données en ensemble d'entraînement (80%) et de test (20%) pour vérifier la précision des prédictions (Backtesting).

- Déploiement et Visualisation :

- Génération de tableaux de bord (via Looker Studio ou Streamlit) présentant les "Mots-clés à surveiller le mois prochain".

- Automatisation des alertes pour les créateurs de contenu.

3. L'Architecture Technique du GEO : Comprendre la Machine pour Mieux l'Optimiser

3.1 Le Fonctionnement des Moteurs RAG (Retrieval-Augmented Generation)

Pour optimiser pour 2026, il est crucial de comprendre l'architecture technique sous-jacente des moteurs comme Gemini ou Perplexity. Ils reposent majoritairement sur le modèle RAG (Retrieval-Augmented Generation).

Contrairement à un LLM pur (comme GPT-4 brut) qui ne connaît que ce qu'il a appris lors de son entraînement (et dont les connaissances sont figées à une date passée), un moteur RAG combine deux étapes :

- La Récupération (Retrieval) : Le système effectue une recherche en temps réel dans son index pour trouver des documents pertinents et frais.

- La Génération (Augmented Generation) : Le système injecte ces documents comme "contexte" dans le prompt du LLM et lui demande de synthétiser une réponse basée uniquement sur ces sources.

Pour le GEO, cela signifie que votre contenu doit réussir deux épreuves : être sélectionné par l'algorithme de récupération (SEO classique/technique) ET être intelligible et priorisé par le LLM lors de la synthèse. Si le LLM n'arrive pas à extraire les faits de votre page, vous ne serez pas cité, même si vous étiez techniquement en première position.

3.2 La Recherche Vectorielle et les Embeddings

Le cœur de la compréhension sémantique en 2026 est la recherche vectorielle. Les moteurs ne cherchent plus des correspondances exactes de mots-clés. Ils transforment le texte en vecteurs numériques (embeddings) placés dans un espace multidimensionnel. Deux concepts sémantiquement proches (par exemple "vélo" et "bicyclette", ou "SEO" et "Référencement") auront des vecteurs mathématiquement proches (distance cosinus faible).

Implication Stratégique : Le bourrage de mots-clés est définitivement mort. Il faut optimiser pour la couverture sémantique. Il s'agit d'utiliser tout le champ lexical, les synonymes, et les concepts connexes (LSI - Latent Semantic Indexing) pour que le vecteur de votre page soit aligné avec le vecteur de la requête utilisateur. Les outils d'optimisation de contenu de 2026 analysent cette densité vectorielle pour suggérer des termes manquants qui renforceraient la pertinence globale du sujet.

3.3 Le "Grounding" : L'Importance de la Citation

Les hallucinations (l'invention de faits par l'IA) restent le risque majeur des LLM. Pour y remédier, les moteurs imposent des mécanismes de "Grounding" (ancrage). Le modèle est pénalisé s'il affirme quelque chose qu'il ne peut pas sourcer explicitement dans les documents récupérés.

C'est ici que se joue la bataille de la citation. Pour être la source d'ancrage ("Grounding Source"), votre contenu doit présenter l'information de manière factuelle, structurée et sans ambiguïté. Les phrases déclaratives simples ("X est Y") sont plus faciles à utiliser pour l'ancrage que les phrases nuancées, ironiques ou interrogatives. Le GEO consiste donc à fournir à l'IA les "briques de vérité" dont elle a besoin pour construire sa réponse en toute sécurité.

4. Ingénierie de Contenu et Stratégie Éditoriale 2026

4.1 La Méthodologie "Answer-First" et la Pyramide Inversée

L'attention des IA (et des humains) est limitée. En 2026, la structure éditoriale gagnante est celle du journalisme classique : la pyramide inversée, adaptée au format "Answer-First" (La réponse d'abord).

L'introduction d'un contenu ne doit plus être une longue mise en bouche contextuelle. Elle doit fournir la réponse directe, complète et synthétique à la question principale (H1) dès les premières lignes. C'est ce paragraphe (souvent appelé le "chapô" ou le "lead") que les algorithmes extraient pour générer les Featured Snippets et les réponses vocales.

Structure type d'un article optimisé GEO :

- H1 : La requête utilisateur principale (souvent une question).

- Réponse Directe (Target Paragraph) : 40 à 60 mots résumant la réponse de manière factuelle. C'est la cible principale pour l'extraction.

- Développement (The "Why" and "How") : Explications détaillées, nuances, contexte.

- Données Structurées : Tableaux, listes à puces, graphiques.

- Gain d'Information : Éléments uniques (voir ci-dessous).

4.2 Le Concept de "Gain d'Information" (Information Gain)

Face à l'inondation de contenu généré par IA qui ne fait que reformuler l'existant, Google a breveté et implémenté le score de "Gain d'Information". Ce critère évalue ce qu'un document apporte de nouveau par rapport au corpus déjà indexé. Si votre article répète ce que disent les 10 premiers résultats, son score de gain d'information est nul, et il sera ignoré par les modèles génératifs qui cherchent à réduire la redondance.

Pour maximiser ce score, il faut injecter de l'originalité irréductible :

- Données Propriétaires : Sondages, études internes, statistiques issues de votre activité.

- Expérience Vécue : Anecdotes personnelles, photos originales, tests physiques de produits ("J'ai testé pour vous...").

- Expertise Humaine : Opinions tranchées, analyses contrariennes, prévisions d'experts reconnus.

Le contenu "moyen" est mort. Seul le contenu qui ajoute une pièce unique au puzzle de la connaissance globale survit.

4.3 Structuration Technique : Schema.org et le Web Sémantique

Si le contenu est roi, la structure est la reine. En 2026, l'utilisation des données structurées (Schema.org) n'est plus optionnelle. C'est le langage par lequel vous expliquez explicitement aux machines ce que contient votre page.

Il ne s'agit plus seulement de baliser des recettes ou des avis. Il faut baliser l'intégralité des entités :

- Speakable : Pour indiquer les sections à lire à voix haute par les assistants.

- FAQPage : Pour structurer les questions/réponses et faciliter leur extraction directe.

- ProfilePage et Person : Pour lier le contenu à l'auteur et renforcer l'E-E-A-T.

- TechArticle ou Report : Pour qualifier la nature profonde du document.

Les sites qui déploient une stratégie de données structurées exhaustive et imbriquée (nested schemas) bénéficient d'un taux de citation nettement supérieur dans les résultats SGE.

5. Le Paradigme "Entity-First" et l'E-E-A-T

5.1 Du Mot-Clé à l'Entité

Comme évoqué dans l'analyse technique, les moteurs "pensent" en entités. Une entité est un objet (personne, lieu, concept) unique et défini dans le Knowledge Graph. Pour Google, "Apple" n'est pas un mot, c'est soit l'entité Apple (Fruit), soit l'entité Apple Inc. (Company).

La stratégie SEO de 2026 doit se focaliser sur la construction de l'autorité de l'entité "Marque" et de l'entité "Auteur". Si Google ne comprend pas qui vous êtes, ce que vous vendez, et quelle est votre légitimité, vous serez invisible.

5.2 E-E-A-T : Le Filtre de Confiance Ultime

L'E-E-A-T (Expérience, Expertise, Autorité, Fiabilité) est devenu le filtre principal pour séparer le bon grain de l'ivraie (le contenu IA de masse).

- Expérience : C'est le nouvel ajout critique. Google veut voir la preuve que l'auteur a réellement vécu ce dont il parle. Cela se traduit par l'utilisation du "Je", des photos non-stock, et des détails sensoriels.

- Autorité et Trust : Ces signaux se construisent hors-site. Les mentions dans la presse, les liens depuis des sites gouvernementaux ou éducatifs, et les profils vérifiés sur les réseaux sociaux consolident le "Trust Rank" de l'entité. Une marque citée régulièrement dans des contextes positifs par d'autres entités d'autorité verra son contenu favorisé algorithmiquement.

5.3 Les Clusters de Contenu et l'Autorité Topique

Pour être reconnu comme une entité experte, il faut couvrir un sujet dans son intégralité. La stratégie des "Topic Clusters" (grappes de contenu) est indispensable. Un site ne doit pas avoir un seul article sur "L'assurance vie", mais une "page pilier" liée à cinquante articles satellites couvrant chaque sous-question (fiscalité, succession, rachat, comparatif, etc.).

Cette densité de contenu interconnecté envoie un signal fort d'Autorité Topique (Topical Authority). Les moteurs privilégient les sites qui traitent un sujet en profondeur ("Depth") plutôt que ceux qui survolent tout en surface ("Breadth"). C'est la fin des sites généralistes non-médias.

6. Nouveaux Indicateurs et Mesure de la Performance

6.1 Au-delà du Classement : Share of Voice (SOV) et Visibilité IA

Le suivi de positionnement classique ("Je suis 3ème sur tel mot-clé") perd de son sens dans un monde de SERP personnalisées et dynamiques. Le nouvel indicateur roi est le Share of Voice (SOV) IA.

Il mesure la fréquence à laquelle votre marque est citée dans les réponses générées pour un ensemble de prompts donnés. Des outils spécialisés permettent désormais de "sonder" les LLM (ChatGPT, Gemini, Perplexity) avec des milliers de questions pour calculer ce taux de présence. Être la "réponse par défaut" de l'IA est le nouveau Graal, remplaçant la "Position 0".

6.2 Analyse de Sentiment et Recommandation

Il ne suffit pas d'être cité ; il faut être recommandé. L'analyse de sentiment IA évalue comment l'IA parle de vous. Est-ce une citation neutre ("X est une entreprise du secteur"), une recommandation positive ("Pour ce besoin, X est la meilleure solution"), ou une mention comparative défavorable?

Le GEO inclut donc une dimension de gestion de réputation (e-Reputation) beaucoup plus fine. Influencer les sources que l'IA utilise (comme les sites d'avis, Reddit, ou les comparateurs tiers) devient une tactique SEO directe pour améliorer ce sentiment.

6.3 Mesurer le "Zero-Click" et l'Impact Business

Paradoxalement, la baisse du trafic n'est pas synonyme de baisse de chiffre d'affaires. Les utilisateurs qui cliquent encore (les "clics résiduels") sont beaucoup plus engagés. Ils ont lu le résumé IA, n'ont pas été satisfaits, et cherchent une expertise profonde.

Les KPIs business (Conversions, Revenu par Visite) doivent être décorrélés du volume de sessions. On observe souvent une augmentation du taux de conversion malgré une baisse du trafic global, car le trafic de "touristes" (simple curiosité) est absorbé par l'IA.

7. Spécificités des Plateformes : Google, ChatGPT, Perplexity

7.1 Google (AI Overviews & Gemini)

Google reste dominant mais hybride. Sa SGE valorise énormément l'E-E-A-T et les données structurées. Il privilégie les sources qui ont un historique de fiabilité technique et de liens entrants de qualité. L'intégration de YouTube dans les sources de SGE est massive : les vidéos sont une source d'information majeure pour Google.

7.2 ChatGPT (OpenAI) et SearchGPT

ChatGPT, avec sa fonctionnalité de recherche web (SearchGPT), a des critères différents. Il semble plus "agnostique" en termes d'autorité de domaine pure (DR/DA) que Google, mais valorise énormément la clarté sémantique et la concordance directe avec le prompt. Il puise largement dans les sources textuelles "ouvertes" et les bases de connaissances bien structurées. Il est moins sensible aux backlinks, mais très sensible à la cohérence du texte.

7.3 Perplexity et les Moteurs de "Découverte"

Perplexity se positionne comme un moteur de citation académique grand public. Il cite systématiquement ses sources avec des notes de bas de page. Pour performer sur Perplexity, il faut avoir un contenu très factuel, riche en chiffres et en données, qui sert de "preuve" à l'argumentaire généré. Perplexity valorise les sources primaires (études, rapports).

8. Le Contexte du Marché Français

8.1 Régulation et Souveraineté Numérique

Le marché français présente des particularités fortes dues au cadre réglementaire européen. Le RGPD (Règlement Général sur la Protection des Données) et le DMA (Digital Markets Act) influencent la manière dont les données sont collectées et affichées. Les moteurs de recherche doivent être plus prudents avec les données personnelles et le droit d'auteur (Droits Voisins).

Pour les éditeurs français, cela signifie qu'une conformité stricte et transparente peut devenir un atout de confiance (Trust Signal). Héberger ses données en France et afficher des politiques de confidentialité claires rassure les utilisateurs et les plateformes soucieuses de conformité.

8.2 L'Écosystème Média et Agences en France

La France dispose d'un écosystème SEO mature et sophistiqué. Des experts reconnus prônent depuis longtemps des approches scientifiques et sémantiques qui s'avèrent visionnaires pour l'ère de l'IA.

Les agences françaises leaders ont pivoté vers des offres GEO. Les études montrent que les médias français spécialisés (presse tech, santé, juridique) résistent mieux à l'érosion du trafic que les généralistes, grâce à une autorité thématique forte et une marque reconnue par les lecteurs français.

9. Études de Cas et Applications Sectorielles

9.1 E-commerce : L'Exemple de "Smart Rent" et "Simplified SEO"

Des études de cas récentes montrent l'impact du GEO.

- Simplified SEO Consulting : En appliquant des stratégies AEO/GEO (contenu basé sur les questions, FAQ structurées, maillage interne strict), cette entité est passée de 1 à 23 mots-clés positionnés en première page en 3 mois, malgré un site techniquement contraint. Cela prouve que la pertinence sémantique peut surpasser la puissance technique brute.

- Smart Rent : Dans le secteur technologique, une optimisation ciblée pour les citations IA a entraîné une hausse de 32 % des leads et un boost de 200 % de la visibilité dans les recherches IA. Le levier principal a été la validation de l'expertise et la structuration des données produits.

9.2 Médias : La Prime à la Spécialisation

Une analyse du marché média français révèle que sur ChatGPT, les médias spécialisés et à forte identité de marque performent mieux. Pour les requêtes d'actualité, les sources traditionnelles (Le Monde, AFP) dominent, mais pour les requêtes "Lifestyle" ou "Conseils", les blogs spécialisés et les forums de niche (UGC) prennent souvent le pas sur les grands médias généralistes, car ils offrent une expérience plus "authentique" et détaillée.

10. Feuille de Route Opérationnelle 2026

Pour naviguer dans ce nouvel environnement, les entreprises doivent adopter une feuille de route claire et ambitieuse.

Phase 1 : Audit et Fondation (Mois 1-3)

- Audit de Visibilité IA : Utiliser des outils comme Search Atlas ou Semrush AI Visibility pour cartographier la présence actuelle de la marque sur les prompts clés.

- Restructuration Technique : Implémenter le balisage Schema.org de manière exhaustive (au-delà du basique). Nettoyer le contenu obsolète (Content Pruning) pour concentrer l'autorité.

- Formation des Équipes : Former les rédacteurs à l'écriture "Answer-First" et les SEO à l'analyse de données Python.

Phase 2 : Accélération Prédictive (Mois 4-9)

- Déploiement des Modèles Prédictifs : Mettre en place les pipelines de données (GSC -> BigQuery -> Prophet) pour anticiper les tendances saisonnières à 3-6 mois.

- Campagnes de Digital PR : Lancer des campagnes visant à obtenir des citations sur des sites d'autorité pour nourrir le Knowledge Graph.

- Stratégie Vidéo : Investir dans la production vidéo YouTube avec transcriptions optimisées pour capturer la visibilité SGE.

Phase 3 : Domination et Diversification (Mois 10+)

- Optimisation Agentique : Préparer les API et les parcours utilisateurs pour qu'ils soient accessibles aux agents autonomes (réservation, achat sans friction).

- Diversification des Canaux : Réduire la dépendance à Google en construisant des audiences propriétaires (Newsletters, App) et en investissant sur les réseaux sociaux "Moteurs de recherche" (TikTok, Pinterest).

Annexes Techniques

Annexe A : Outils et Stack Technologique Recommandée

| Outil | Usage Principal 2026 |

|---|---|

| Python (Pandas, Prophet) | Modélisation prédictive, analyse de séries temporelles, nettoyage de données GSC. |

| Semrush (AI Visibility) | Suivi du Share of Voice IA, analyse de la concurrence dans les résumés génératifs. |

| Oncrawl / Screaming Frog | Audit technique profond, validation des données structurées, analyse de logs pour les crawlers IA. |

| Surfer SEO / MarketMuse | Optimisation sémantique, analyse de la densité vectorielle, score de contenu. |

| Exploding Topics | Détection de signaux faibles et tendances émergentes avant qu'elles n'apparaissent dans les outils classiques. |

Annexe B : Glossaire Avancé

- Agentic SEO : Optimisation pour les agents IA autonomes capables d'exécuter des tâches.

- Embeddings : Représentation vectorielle de mots ou de phrases capturant leur sens sémantique.

- Grounding (Ancrage) : Processus par lequel une IA lie sa réponse à une source vérifiable pour éviter les hallucinations.

- Hallucination : Erreur factuelle générée par un LLM.

- Knowledge Graph : Base de connaissances structurée reliant des entités (personnes, lieux, choses) et leurs relations.

- Prompt Engineering (pour SEO) : Art de structurer le contenu pour qu'il serve de "réponse parfaite" à un prompt utilisateur probable.

- Zero-Click Search : Recherche où l'utilisateur obtient sa réponse directement sur la SERP sans visiter de site web.

Questions Fréquentes

Qu'est-ce que le Moteur de Réponse ?

C'est l'évolution du moteur de recherche qui, via l'IA générative (SGE), digère et reformule l'information pour offrir une réponse synthétique immédiate, réduisant les clics sortants.

Qu'est-ce que l'Agentic SEO ?

C'est l'optimisation pour les agents autonomes capables de planifier et d'exécuter des tâches complexes. Il s'agit de rendre le contenu et les services interopérables pour ces 'consommateurs machines'.

Quelle est la différence entre SEO et GEO ?

Le SEO vise à classer des liens dans une liste, tandis que le GEO (Generative Engine Optimization) vise à influencer les modèles de langage pour être cité ou recommandé dans une réponse générée.

Qu'est-ce que le SEO Prédictif ?

C'est une approche utilisant la data science et le machine learning pour anticiper la demande et les tendances avant qu'elles ne se matérialisent, contrairement au SEO réactif basé sur le passé.

Qu'est-ce que le Gain d'Information ?

C'est un critère utilisé par Google pour évaluer ce qu'un document apporte de nouveau par rapport au corpus existant. Un score élevé est crucial pour être cité par les modèles génératifs.

Conclusion : L'Adaptation comme Seule Constante

En 2026, le SEO est devenu une discipline d'élite. La barrière à l'entrée s'est élevée : il ne suffit plus de publier du contenu moyen avec quelques mots-clés. Il faut être une entité, une autorité, une marque.

L'avenir appartient à ceux qui sauront allier l'excellence éditoriale humaine (pour l'E-E-A-T et le Gain d'Information) à la puissance de l'analyse prédictive (pour le timing et la pertinence). Anticiper Google en 2026, ce n'est pas essayer de tromper la machine, c'est devenir la source de vérité que la machine ne peut pas ignorer.

📑 Sommaire

- Sommaire Exécutif

- 1. La Grande Mutation : Du Moteur de Recherche au Moteur de Réponse (2025-2026)

- 1.1 L'Effondrement du Modèle des "Dix Liens Bleus"

- 1.2 L'Ère de l'Internet Agentique et Autonome

- 1.3 La Nouvelle Hiérarchie : AEO, GEO et Search Everywhere

- 2. Le SEO Prédictif : La Science de la Donnée au Service de l'Anticipation

- 2.1 Définition et Rupture avec le SEO Réactif

- 2.2 Méthodologies et Algorithmes de Prévision

- 2.3 Workflow Technique : Construire un Modèle Prédictif en Python

- 3. L'Architecture Technique du GEO : Comprendre la Machine pour Mieux l'Optimiser

- 3.1 Le Fonctionnement des Moteurs RAG (Retrieval-Augmented Generation)

- 3.2 La Recherche Vectorielle et les Embeddings

- 3.3 Le "Grounding" : L'Importance de la Citation

- 4. Ingénierie de Contenu et Stratégie Éditoriale 2026

- 4.1 La Méthodologie "Answer-First" et la Pyramide Inversée

- 4.2 Le Concept de "Gain d'Information" (Information Gain)

- 4.3 Structuration Technique : Schema.org et le Web Sémantique

- 5. Le Paradigme "Entity-First" et l'E-E-A-T

- 5.1 Du Mot-Clé à l'Entité

- 5.2 E-E-A-T : Le Filtre de Confiance Ultime

- 5.3 Les Clusters de Contenu et l'Autorité Topique

- 6. Nouveaux Indicateurs et Mesure de la Performance

- 6.1 Au-delà du Classement : Share of Voice (SOV) et Visibilité IA

- 6.2 Analyse de Sentiment et Recommandation

- 6.3 Mesurer le "Zero-Click" et l'Impact Business

- 7. Spécificités des Plateformes : Google, ChatGPT, Perplexity

- 7.1 Google (AI Overviews & Gemini)

- 7.2 ChatGPT (OpenAI) et SearchGPT

- 7.3 Perplexity et les Moteurs de "Découverte"

- 8. Le Contexte du Marché Français

- 8.1 Régulation et Souveraineté Numérique

- 8.2 L'Écosystème Média et Agences en France

- 9. Études de Cas et Applications Sectorielles

- 9.1 E-commerce : L'Exemple de "Smart Rent" et "Simplified SEO"

- 9.2 Médias : La Prime à la Spécialisation

- 10. Feuille de Route Opérationnelle 2026

- Phase 1 : Audit et Fondation (Mois 1-3)

- Phase 2 : Accélération Prédictive (Mois 4-9)

- Phase 3 : Domination et Diversification (Mois 10+)

- Annexes Techniques

- Annexe A : Outils et Stack Technologique Recommandée

- Annexe B : Glossaire Avancé

- Conclusion : L'Adaptation comme Seule Constante